オフラインでLLMを実行する(DeepSeek-R1-Distill-Qwen × Ollamaの導入手順)

はじめに

DeepSeekが話題になっていますね。

どうやらローカル環境で動かせるようで、いい機会なので話題になっている内に触ってみたいと思います。CUI(ollama)での実行に加えて、やってる感を出したいのでGUI(ollama + Open WebUI)での実行を行います。

といいつつDeepSeek-R1ではなく、サイバーエージェントが2025年1月27日に公開したDeepSeek-R1-Distill-Qwen-14B/32B-Japaneseを利用します。

【モデル公開のお知らせ】

DeepSeek-R1-Distill-Qwen-14B/32Bをベースに日本語データで追加学習を行ったLLMを公開いたしました。今後もモデル公開や産学連携を通じて国内の自然言語処理技術の発展に貢献してまいります。 https://t.co/Oi0l2ITzhh— サイバーエージェント 広報&IR (@CyberAgent_PR) January 27, 2025

PC環境

- OS: Windows 10

- CPU: Intel Core i9-12900K

- RAM: 32GB

- GPU:GeForce RTX4090

Ollamaとは?

Ollama は、ローカル環境で簡単にLLMを実行できるプラットフォームです。コマンドラインベースでモデルのダウンロード・管理・推論が可能ですが、GUIツールと組み合わせることで視覚的にモデルの動作を確認できます。

特長

- 軽量でシンプル:Dockerのような重い環境を不要

- 多くのLLMに対応:Llama、Mistral、DeepSeek などのモデルを簡単に利用可能

- ローカルで完結:クラウドなしでプライバシーを保ちながら利用可能

CUI(ollama)で実行する手順

Ollamaのインストール

- Ollamaの公式サイト(https://ollama.com/)にアクセス

- Windows用インストーラー をダウンロード

- インストーラーを実行し、指示に従ってセットアップ

- ターミナル(cmd / PowerShell)で以下を実行し、インストール確認

ollama --version

DeepSeek-R1-Distill-Qwen-14B/32B-Japaneseの導入

Ollama経由で簡単に利用できますが、10GBと結構な容量を取るので注意です。

- ターミナル(cmd / PowerShell)で以下を実行し、モデルをダウンロード

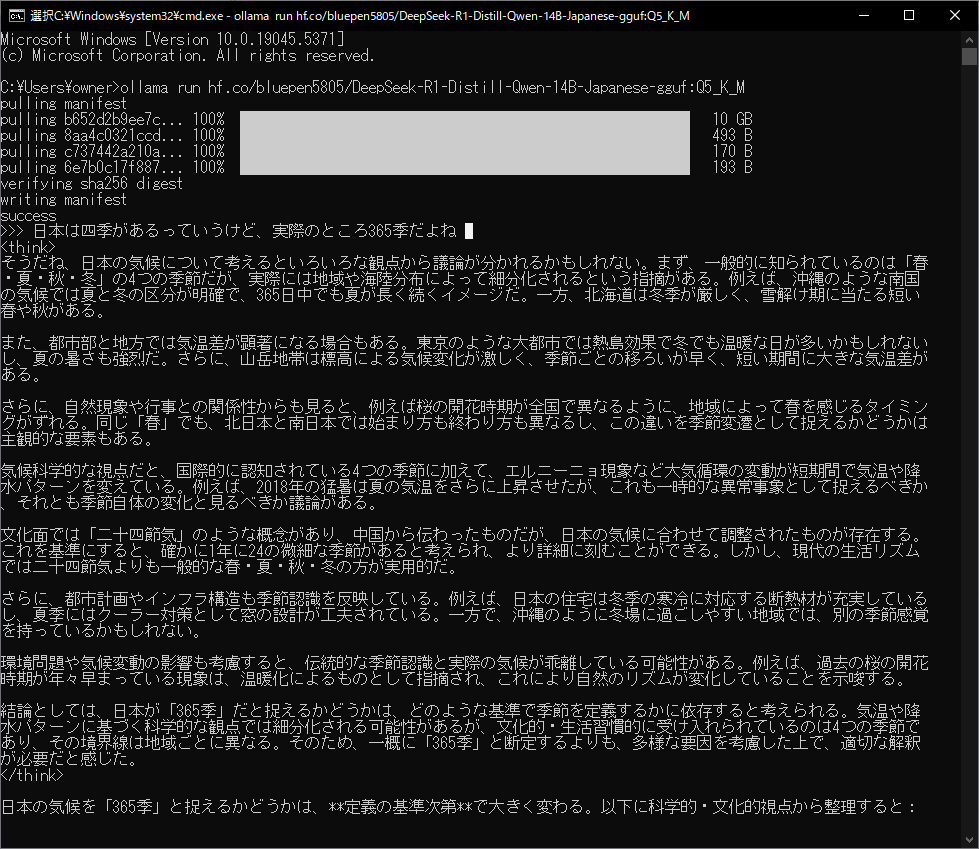

ollama run hf.co/bluepen5805/DeepSeek-R1-Distill-Qwen-14B-Japanese-gguf:Q5_K_M

ダウンロードが終わった後は、そのまま実行可能状態となります。

LLMに対して好きな質問を行い、回答が返ってくることを確認しましょう。

CUIでの実行

導入は以上で終わりです。非常に簡単ですね!

あとはLLMとの会話を行ってCUIでの実行を完了とします。今回は以下の質問を行いました。

日本は四季があるっていうけど、実際のところ365季だよね

これに対する回答が以下です。ちょっとした疑問程度に対する回答が長い...長すぎる。

まぁ回答がもらえたのでよしとします!

<think>

そうだね、日本の気候について考えるといろいろな観点から議論が分かれるかもしれない。まず、一般的に知られているのは「春・夏・秋・冬」の4つの季節だが、実際には地域や海陸分布によって細分化されるという指摘がある。例えば、沖縄のような南国の気候では夏と冬の区分が明確で、365日中でも夏が長く続くイメージだ。一方、北海道は冬季が厳しく、雪解け期に当たる短い春や秋がある。また、都市部と地方では気温差が顕著になる場合もある。東京のような大都市では熱島効果で冬でも温暖な日が多いかもしれないし、夏の暑さも強烈だ。さらに、山岳地帯は標高による気候変化が激しく、季節ごとの移ろいが早く、短い期間に大きな気温差がある。

さらに、自然現象や行事との関係性からも見ると、例えば桜の開花時期が全国で異なるように、地域によって春を感じるタイミングがずれる。同じ「春」でも、北日本と南日本では始まり方も終わり方も異なるし、この違いを季節変遷として捉えるかどうかは主観的な要素もある。

気候科学的な視点だと、国際的に認知されている4つの季節に加えて、エルニーニョ現象など大気循環の変動が短期間で気温や降水パターンを変えている。例えば、2018年の猛暑は夏の気温をさらに上昇させたが、これも一時的な異常事象として捉えるべきか、それとも季節自体の変化と見るべきか議論がある。

文化面では「二十四節気」のような概念があり、中国から伝わったものだが、日本の気候に合わせて調整されたものが存在する。これを基準にすると、確かに1年に24の微細な季節があると考えられ、より詳細に刻むことができる。しかし、現代の生活リズムでは二十四節気よりも一般的な春・夏・秋・冬の方が実用的だ。

さらに、都市計画やインフラ構造も季節認識を反映している。例えば、日本の住宅は冬季の寒冷に対応する断熱材が充実しているし、夏季にはクーラー対策として窓の設計が工夫されている。一方で、沖縄のように冬場に過ごしやすい地域では、別の季節感覚を持っているかもしれない。

環境問題や気候変動の影響も考慮すると、伝統的な季節認識と実際の気候が乖離している可能性がある。例えば、過去の桜の開花時期が年々早まっている現象は、温暖化によるものとして指摘され、これにより自然のリズムが変化していることを示唆する。

結論としては、日本が「365季」だと捉えるかどうかは、どのような基準で季節を定義するかに依存すると考えられる。気温や降水パターンに基づく科学的な観点では細分化される可能性があるが、文化的・生活習慣的に受け入れられているのは4つの季節であり、その境界線は地域ごとに異なる。そのため、一概に「365季」と断定するよりも、多様な要因を考慮した上で、適切な解釈が必要だと感じた。

</think>日本の気候を「365季」と捉えるかどうかは、**定義の基準次第**で大きく変わる。以下に科学的・文化的視点から整理すると:

---

### **1. 科学的な観点**

- **海陸分布と地域差**

内陸部(関東や近畿)より沿岸部や沖縄では季節の区別が曖昧。沖縄は「夏」が200日超を占め、「冬」も温暖で雨に支配される。

- **標高による変化**

山岳地帯(北海道の支笏湖周辺など)では、冬季に雪解け期があり「春」の短い期間が存在する。

- **短期的な気候変動**

エルニーニョ現象や局所的異常気象(2018年の猛暑)は季節の枠を越え、**1年間で複数回の気温パターンの切り替わり**が発生。---

### **2. 文化的・生活習慣**

- **二十四節気の影響**

日本では「立春」「清明」などの節気を基準にした季節認識があり、より細分化された微細な変化を捉える。

- **行事との連動**

桜の開花や紅葉時期は地域差が顕著で、「春」や「秋」の感覚は南北で異なる。例:東京では4月下旬に満開だが、沖縄では3月から始まる。---

### **3. 都市計画とインフラ**

- **冬の冷暖房対策**

北陸や北海道では冬季専用の断熱材が標準化され、「寒さ」という概念を季節固定で捉える。

- **夏の遮光技術**

都市部ではエアコンの使用に伴い、高温期・低温期という2極性が強調される傾向あり。---

### **4. 気候変動への影響**

- **桜の開花遅延問題**

温暖化により、従来の季節パターン(例:関東で3月中旬の満開)が崩れつつある。これに対応し、桜見ごろ情報を地域別に調整する傾向がある。

- **冬期の異常温帯**

昔より「初雪遅延」や「雪解け早まり」が報告され、冬季の定義が曖昧になっている。---

### **結論**

「365季」という表現は科学的な細分化を指すが、日本では文化的・実用的に**4つの季節(春・夏・秋・冬)**に分類されるのが主流。地域差や短期変動は補足要素であり、生活リズムに根付いた「4季」の概念が機能している。ただし、現代の気候変動により、伝統的な季節認識と実際の自然現象が乖離する可能性も存在する。

GUI(ollama + Open WebUI)で実行する手順

GUIで実行する場合でも、Ollamaのインストールやモデルのダウンロードが必要なのでCUIで実行する手順を全て行う必要があります。

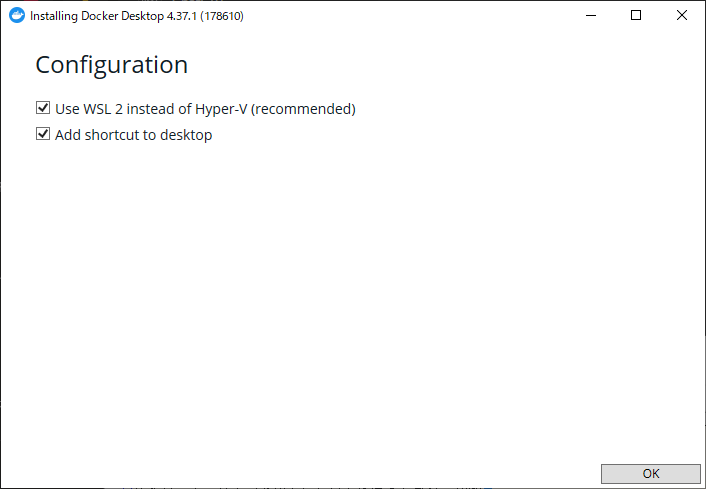

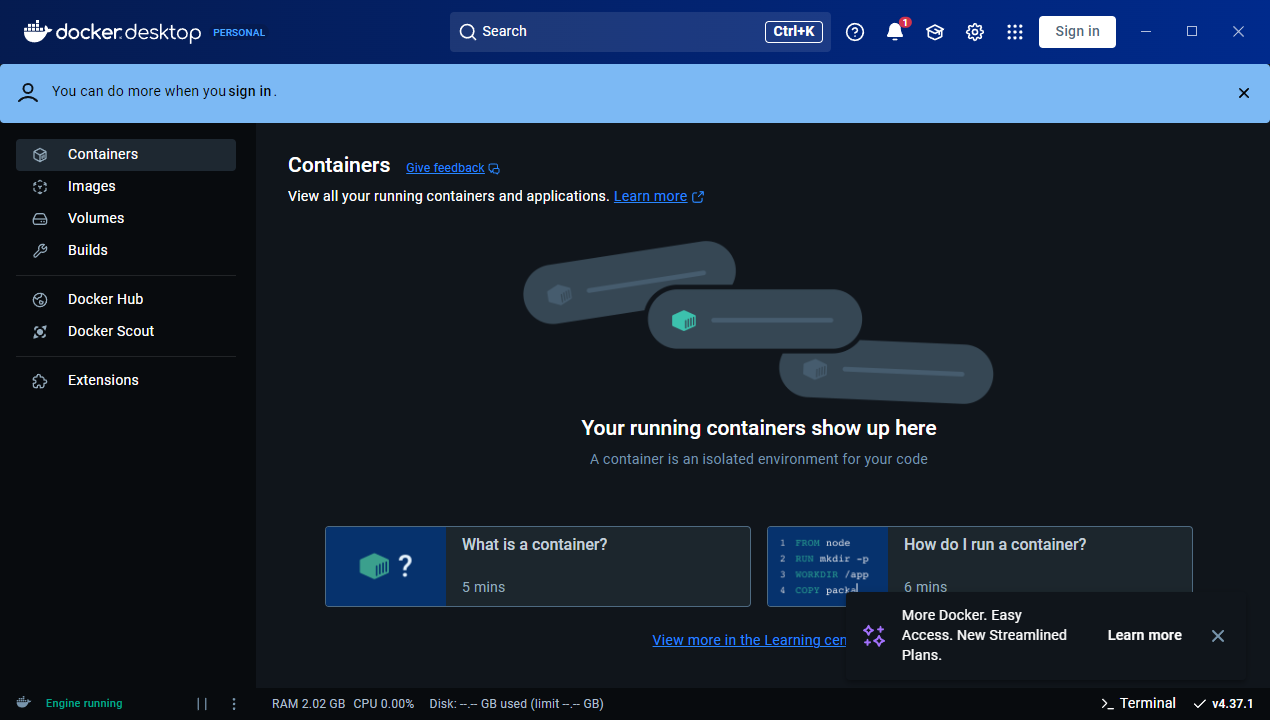

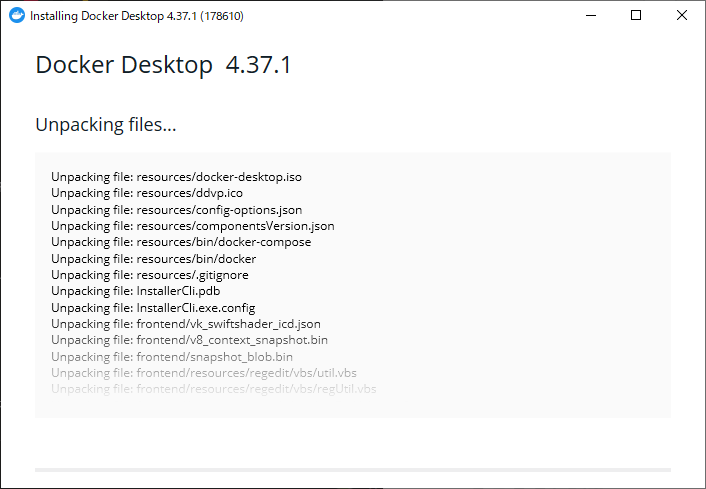

docker desktopのインストール

- Dockerの公式サイト(https://www.docker.com/)にアクセス

- Windows用インストーラー をダウンロード

- インストーラーを実行し、指示に従ってセットアップ

※最後に再起動走るので注意

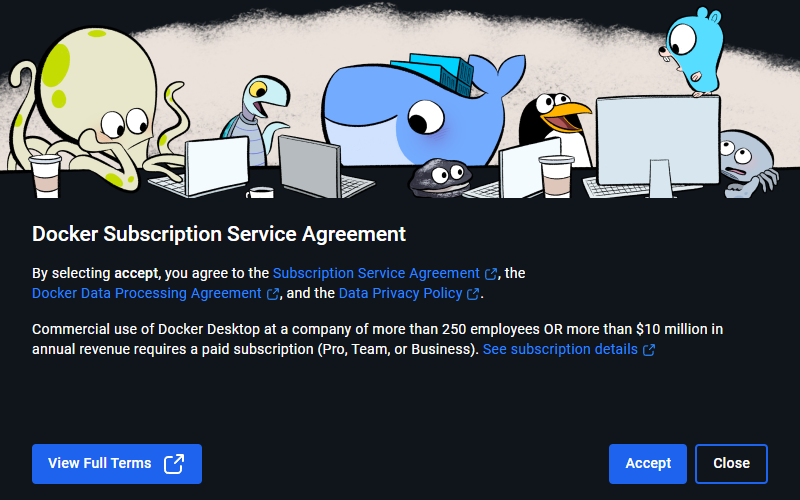

インストーラー起動 - 再起動後に利用規約へのが出ます。個人にはあんまり関係のない内容です。

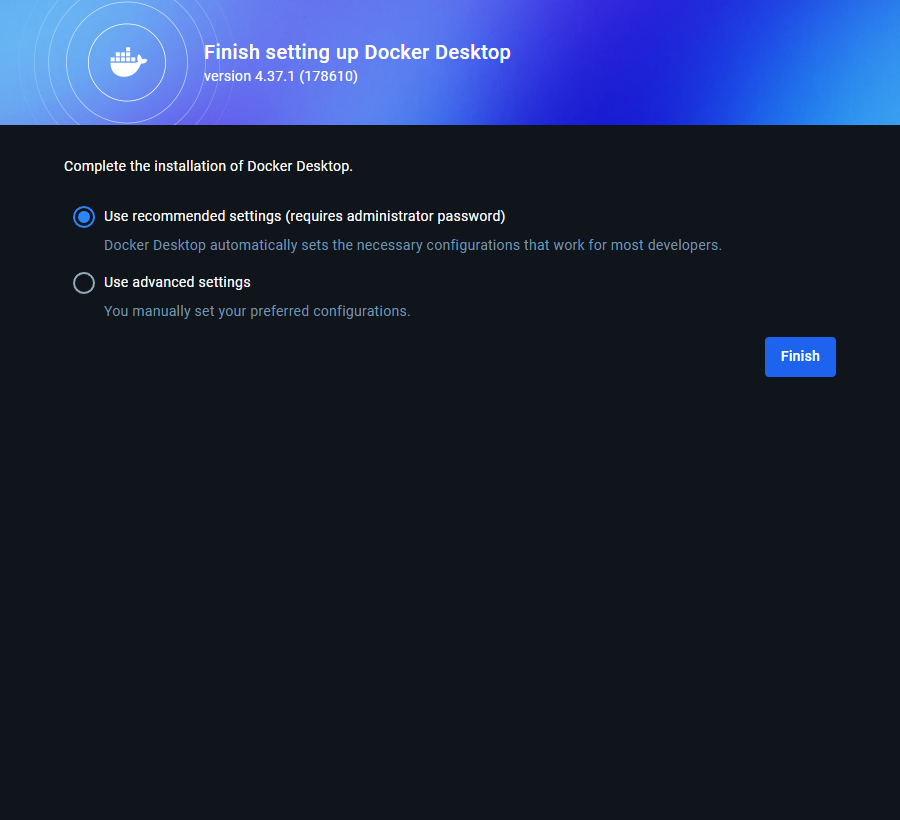

Acceptで規約を承諾します。 - 特に気にしない人は推奨設定のままFinishを押下(気になる方はカスタム設定を行ってください)

- 色々出てきますが、すべてスキップ

- 起動しました!

Open WebUIの導入

dockerコンテナを起動する前準備として、以下のファイルを用意してください。

ファイル名 docker-compose.yaml

services:

ollama:

image: ollama/ollama:latest

container_name: ollama

volumes:

- ollama:/root/.ollama

ports:

- "11434:11434"

restart: unless-stopped

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

ports:

- "3000:8080"

volumes:

- open-webui:/app/backend/data

extra_hosts:

- "host.docker.internal:host-gateway"

restart: always

volumes:

ollama:

name: ollama

open-webui:

name: open-webuiファイルを用意したら、ファイルの存在するディレクトリで以下コマンドを押下

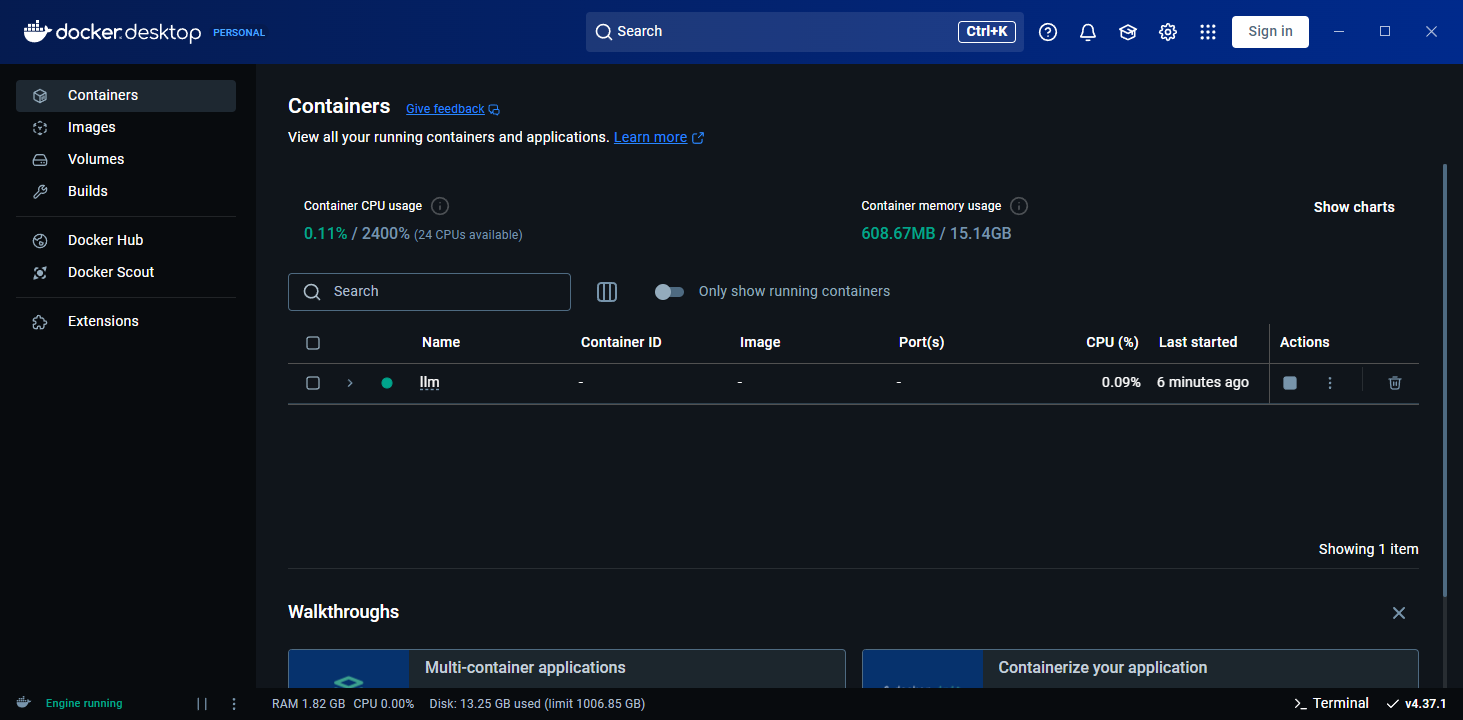

docker compose up -d起動すれば、Docker DesktopのContainersに表示されるはずです。

たまにポートが使用 or 予約されていたりして、起動しないことがあります。その場合はdocker-compose.yamlのportを変更してみてください。

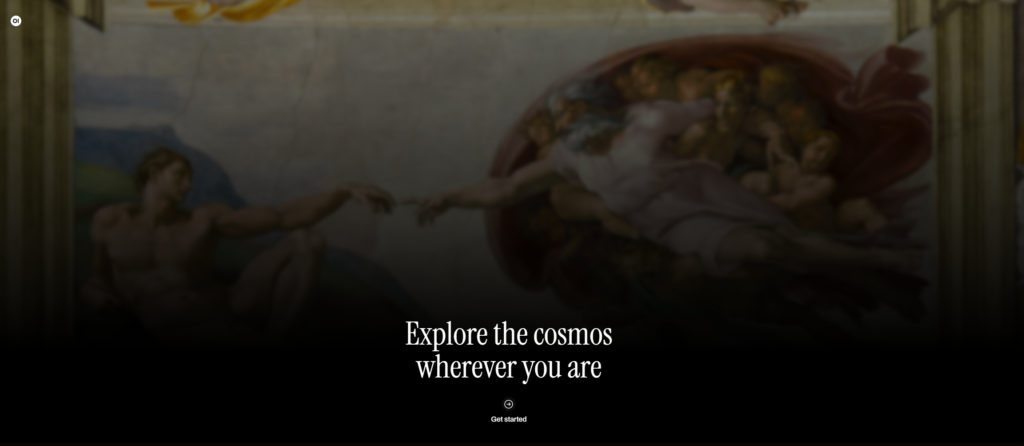

GUIでの実行

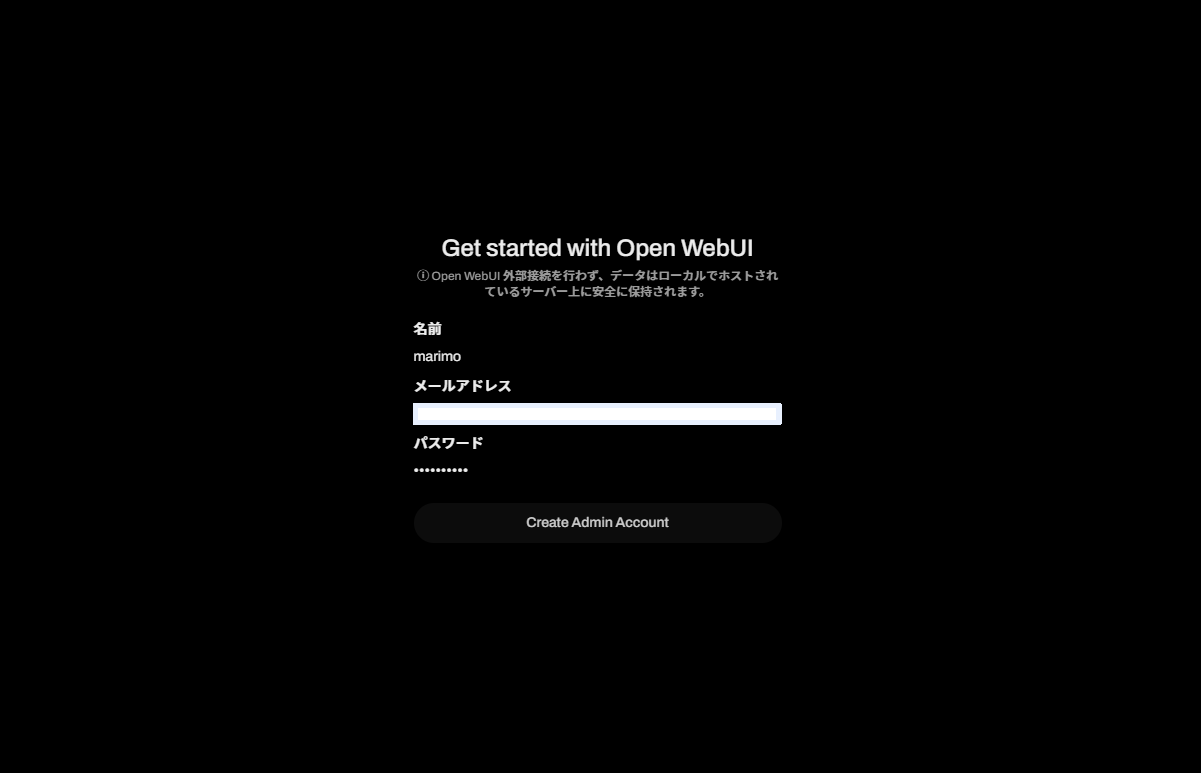

http://localhost:3000/へアクセスしてください。何やらおしゃれな画面に飛びます。

Get startedを押下すると名前やメールアドレス、パスワードを入れるページが表示されます。

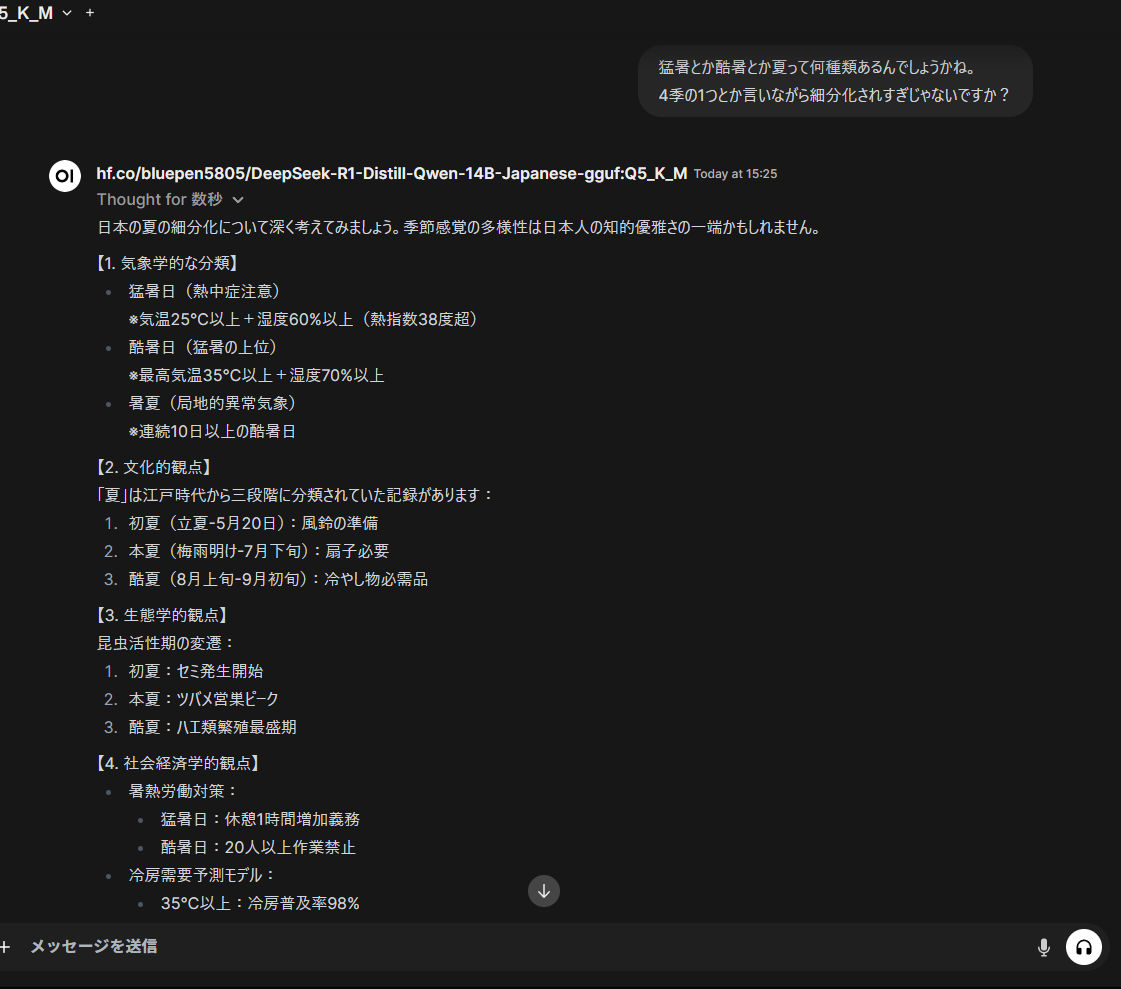

存分にLLMとの会話を楽しんでください!

猛暑とか酷暑とか夏って何種類あるんでしょうかね。

4季の1つとか言いながら細分化されすぎじゃないですか?

日本の夏の細分化について深く考えてみましょう。季節感覚の多様性は日本人の知的優雅さの一端かもしれません。

【1. 気象学的な分類】

猛暑日(熱中症注意)

※気温25℃以上+湿度60%以上(熱指数38度超)

酷暑日(猛暑の上位)

※最高気温35℃以上+湿度70%以上

暑夏(局地的異常気象)

※連続10日以上の酷暑日

【2. 文化的観点】

「夏」は江戸時代から三段階に分類されていた記録があります:初夏(立夏-5月20日):風鈴の準備

本夏(梅雨明け-7月下旬):扇子必要

酷夏(8月上旬-9月初旬):冷やし物必需品

【3. 生態学的観点】

昆虫活性期の変遷:初夏:セミ発生開始

本夏:ツバメ営巣ピーク

酷夏:ハエ類繁殖最盛期

【4. 社会経済学的観点】暑熱労働対策:

猛暑日:休憩1時間増加義務

酷暑日:20人以上作業禁止

冷房需要予測モデル:

35℃以上:冷房普及率98%

30℃以下:扇風機利用頻度67%

【5. 言語哲学的考察】

「夏」の日本語表現が持つ多重性:夏草(涼感)

夏枯れ(熱感)

暑空(炎天)

熱帯夜(蒸し暑さ)

現代的な気象予報では、熱中症リスクを「1級危険」から「4級危険」と四段階に分けます。このように日本人は体感温度の差異を1℃単位で区別する文化があります。海外と比較すると、英語圏の「hot summer」が曖昧な表現に対し、日本語は「猛暑・酷暑・湿熱夏・砂埃夏」といった詳細な描写ができる点に優れています。この細分化は単なる気温測定ではなく、生命維持に関わる深刻な生存戦略の反映と言えるでしょう。例えば、日本の都市計画では「猛暑指数マップ」に基づき、公園緑化や地下空間整備を進めることで熱島現象を緩和する具体的施策が取られています。

一方で、このような分類が生み出す心理的負担も考慮すべきかもしれません。梅雨明け後の連日酷暑に「夏の終わりが見えない」という国民的な苦痛を引き起こす要因ともなっています。しかし同時に、この精密な気象観察は日本独自の生存智慧として継承され、現代社会でもその知恵が災害対策に活かされている点も重要です。

季節感覚の多様性こそが、日本人の気候適応能力を育んだと言えるでしょう。夏という単純な概念を超えた細分化は、実際の生存戦略として機能し続けています。

さいごに

これでネットワーク障害とかが発生しても、ローカル環境で実行できるようになりました。

LLMを取り巻く環境や知識をアップデートしていかないと、すぐに時代に取り残されちゃいそうです。

ディスカッション

コメント一覧

まだ、コメントがありません